El uso ético de herramientas basadas en IA para la educación y el aprendizaje de adultos

La Inteligencia Artificial (IA) es ahora un fenómeno omnipresente. Casi todas las generaciones utilizan múltiples herramientas de IA en la vida cotidiana, para estudiar, en el trabajo y en su tiempo de ocio; de ahí que se espere que "colaboren y cooperen" con la IA en múltiples contextos (Laupichler et al., 2022, p. 2). Mientras tanto, organizaciones de los sectores público y privado están implantando o experimentando con diversas aplicaciones de herramientas impulsadas por IA para apoyar los procesos de trabajo, la prestación de servicios y la formación continua de los empleados. En este sentido, los proveedores de educación públicos y privados no son una excepción, ya que las herramientas basadas en IA, como los sistemas de tutoría inteligente o las aplicaciones de aprendizaje de idiomas, por mencionar algunas, pueden apoyar el desarrollo de programas y las prácticas de enseñanza y aprendizaje.

Herramientas basadas en IA para apoyar la educación y el aprendizaje de adultos

En la educación y el aprendizaje de adultos en instituciones educativas, en el trabajo y en actividades de aprendizaje autodirigido pueden utilizarse diversas herramientas basadas en IA. Entre estas herramientas, los agentes conversacionales son ya habituales. También conocidos como chatbots, son programas informáticos capaces de imitar las conversaciones humanas mediante la interacción de texto o voz. Los chatbots suelen basarse en el aprendizaje automático o en algoritmos aplicados a los datos de entrada que hacen que los dispositivos digitales aprendan y mejoren en una tarea específica, gracias a la identificación de patrones y predicciones. Los chatbots más avanzados, como ChatGPT (Generative Pre-trained Transformer), DeepSeek o similares, también conocidos como IA generativa, pueden procesar grandes cantidades de datos de entrada, aprender de ellos mediante patrones algorítmicos y, finalmente, generar nuevos datos o salidas en forma de texto, imágenes o música (Labadze et al., 2023).

Tanto los educadores como los alumnos pueden utilizar chatbots y herramientas de IA increíblemente generativas para buscar y sintetizar información, producir materiales didácticos (educadores) o síntesis de estudio (alumnos) y producir textos, imágenes o música novedosos. Estas actividades pueden ayudar a educadores y alumnos de muchas maneras, pero algunas son más delicadas que otras desde el punto de vista ético.

Un uso más instrumental, como resumir un texto, es menos problemático (aunque el usuario debe ser consciente de que los resúmenes producidos por las herramientas basadas en IA pueden no captar necesariamente la esencia de un texto como lo habría hecho él). Sin embargo, los usos más significativos, como acceder a información o producir un texto o imagen novedosos, tienen una mayor carga ética. Entablar una conversación con un chatbot requiere la capacidad del usuario de introducir las indicaciones adecuadas para generar resultados satisfactorios. Esto puede estimular el pensamiento crítico del usuario o su capacidad para resolver problemas. Sin embargo, estas conversaciones también requieren la capacidad del usuario para evaluar críticamente la validez de la información recuperada y la fuente de dicha información, que no siempre es conocida por el usuario. Además, se requiere honestidad intelectual para evitar que un usuario reivindique un resultado producido por una herramienta potenciada por IA como su creación original.

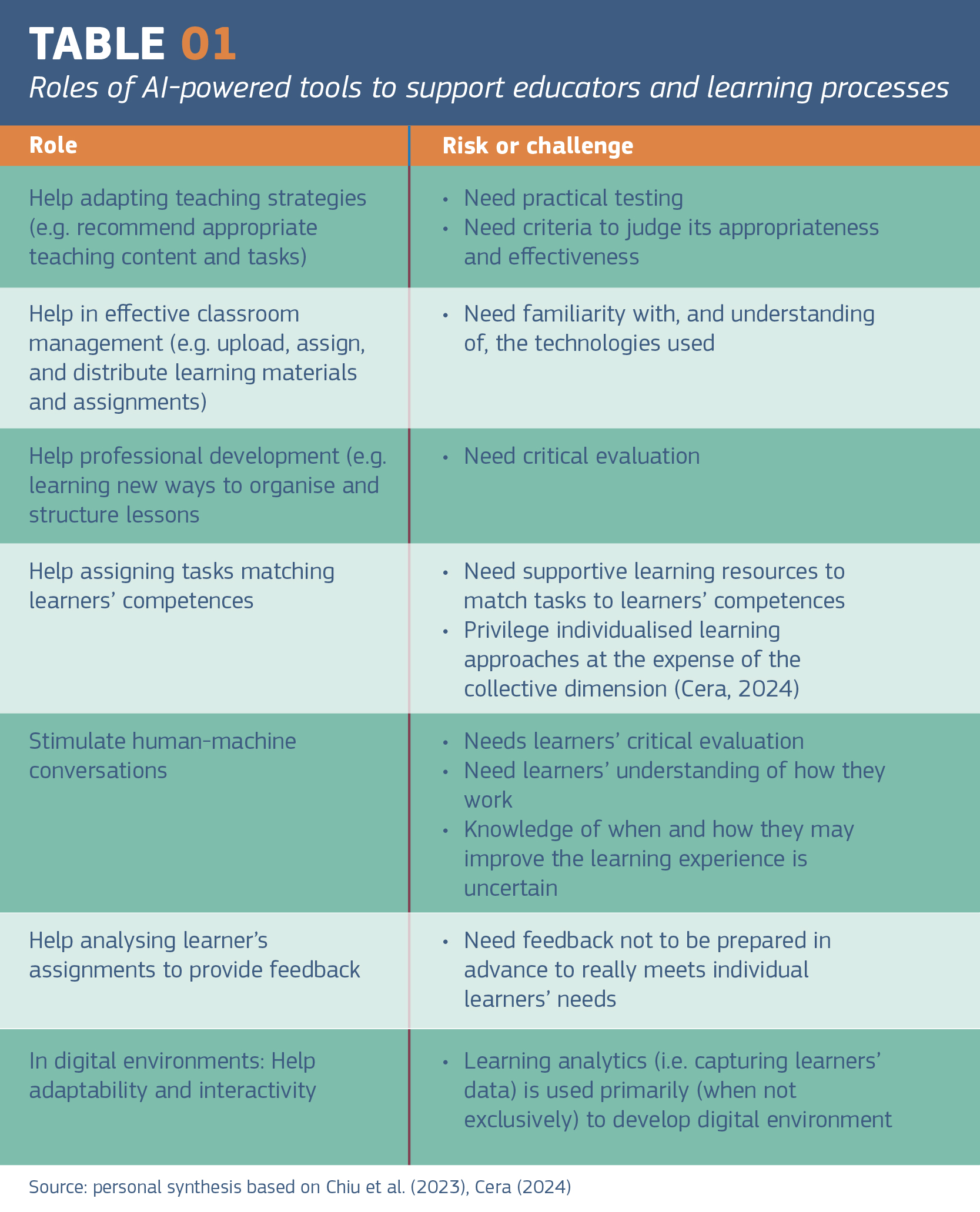

Los investigadores han identificado diferentes funciones de las herramientas basadas en IA para apoyar a los educadores y/o los procesos de aprendizaje (Chiu et al., 2023), que también presentan riesgos o desafíos éticos para producir un aprendizaje significativo (véase el cuadro 1).

Independientemente de las preocupaciones filosóficas, psicológicas o morales que las organizaciones y las personas puedan tener en el uso de herramientas impulsadas por IA, existen dimensiones éticas ineludibles que los proveedores de educación deben tener en cuenta a la hora de desarrollar su oferta. Igualmente importante es que los educadores y los alumnos sean conscientes de las dimensiones éticas de la utilización de herramientas basadas en la IA en las prácticas de enseñanza y aprendizaje (Mouta et al., 2023).

La Ley de IA: el ser humano en el centro

Las preocupaciones éticas están en el centro de la Ley de IA, el marco jurídico europeo aprobado por el Parlamento Europeo y el Consejo para regular el uso eficaz y seguro de la IA. Adoptando un enfoque antropocéntrico, la Ley de IA exige que los resultados de la IA estén siempre bajo control y supervisión humanos y que las tecnologías no afecten a los derechos fundamentales (véase la Carta de los Derechos Fundamentales de la Unión Europea). En consecuencia, la Ley de IA identifica aquellos sistemas de IA que plantean riesgos significativos de daño para la salud, la seguridad o los derechos fundamentales de las personas. En el ámbito de la educación, los sistemas de IA de alto riesgo incluyen los utilizados para controlar el acceso o la admisión en centros educativos, evaluar los resultados del aprendizaje y dirigir el proceso de aprendizaje, y evaluar el nivel académico alcanzado o al que pueden acceder las personas (anexo III de la Ley de IA). Por ello, la Ley de AI prevé que

La alfabetización en IA debe dotar a proveedores, implantadores y afectados de las nociones necesarias para tomar decisiones informadas sobre los sistemas de IA. (Ley de IA, párrafo 20)

¿Alfabetización en IA o capacidades en IA?

La alfabetización en IA puede significar cosas algo diferentes. Una posible definición se refiere a

un conjunto de competencias que permite a las personas evaluar de forma crítica las tecnologías de la IA, comunicarse y colaborar eficazmente con ella y utilizarla como herramienta en línea, en casa y en el lugar de trabajo (Long y Magerko, 2020, p. 2).

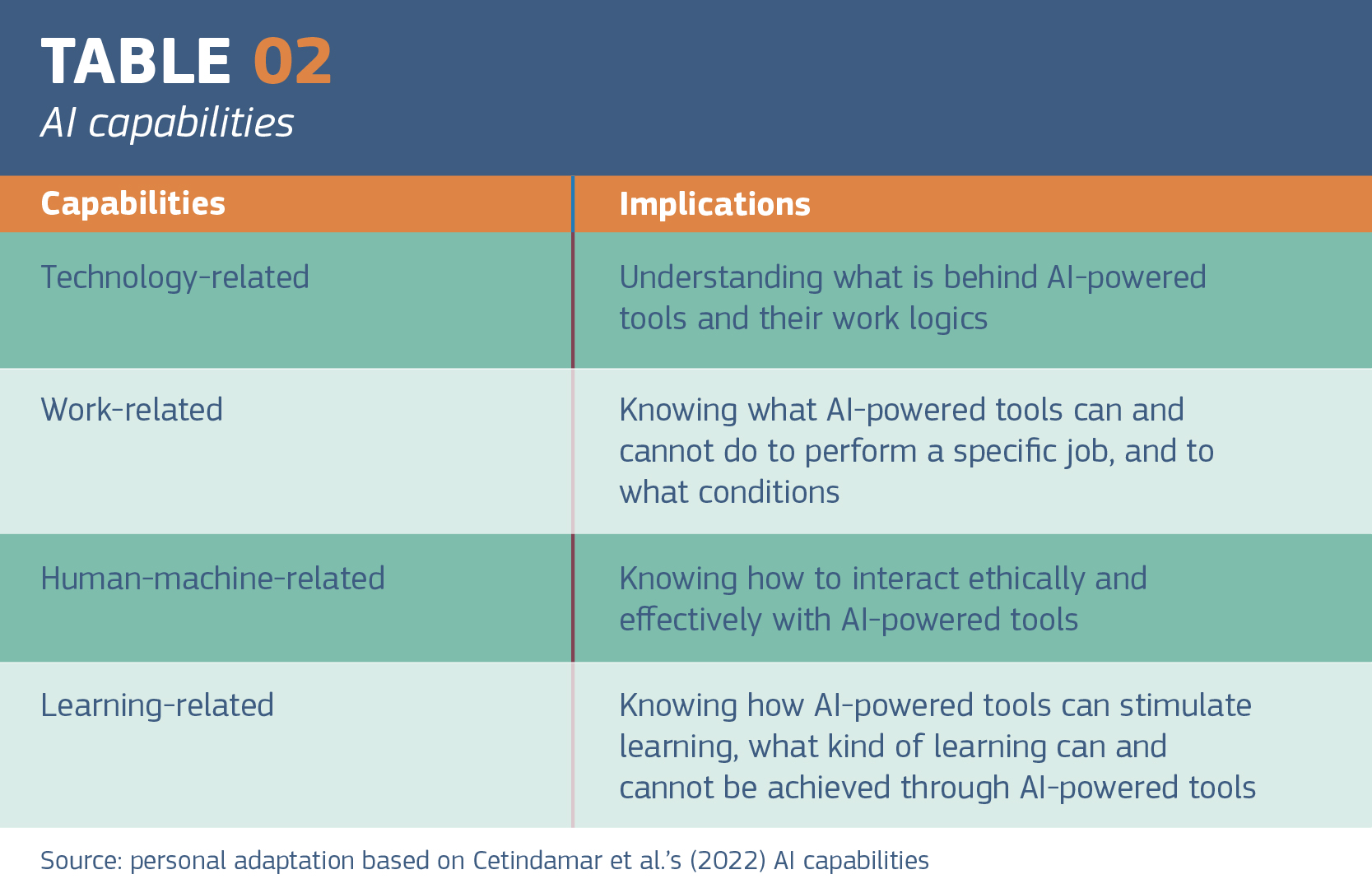

Entendida de este modo, la alfabetización en IA abarca conocimientos específicos y la capacidad de comprender, utilizar, aplicar y evaluar la dimensión ética en la adquisición y creación de nuevos conocimientos a través de herramientas impulsadas por IA, que no se limita a los conocimientos especializados directamente relacionados con las herramientas impulsadas por IA. Por lo tanto, hablar de capacidades de IA en lugar de alfabetización en IA sería más apropiado para garantizar un uso ético de las herramientas impulsadas por IA en diversos contextos, incluidos los entornos educativos y el lugar de trabajo (Cetindamar et al., 2022) (véase el cuadro 2).

Capacidades de IA y códigos de conducta

Para avanzar en su enfoque antropocéntrico y garantizar que las tecnologías no afecten a los derechos fundamentales de las personas, la Ley de IA también prevé un compromiso activo de la Comisión Europea y los Estados miembros para garantizar que se elaboren códigos de conducta voluntarios en cooperación con las partes interesadas.

Aunque a lo largo de los años se han elaborado diferentes manuales o directrices sobre el uso de herramientas basadas en IA dirigidas a educadores y alumnos, como Generative AI in Student-Directed Projects: Advice and Inspiration (descrito aquí), el desarrollo de códigos de conducta es crucial para que los proveedores educativos apoyen una práctica éticamente sólida en el uso de herramientas potenciadas por IA por parte de los educadores y el aprendizaje al tiempo que avanzan en sus capacidades de IA.

Referencias

Cera, R. (2024), Intelligenza artificiale ed educazione continua democratica degli adulti: personalizzazione, pluralismo e inclusione [Artificial intelligence and democratic adult continuing education: personalisation, pluralism and inclusion], Lifelong Lifewide Learning, 22(45), 117-129 https://doi.org/10.19241/lll.v22i45.894

Chiu, T., Xia, Q., Zhou, X., Chai, C. S., & Cheng, M. (2023). Systematic literature review on opportunities, challenges, and future research recommendations of artificial intelligence in education. Computers and Education: Artificial Intelligence, 4, 100118.

Labadze, L., Grigolia, M., & Machaidze, L. (2023). Role of AI chatbots in education: Systematic literature review. International Journal of Educational Technology in Higher Education, 20, 56.

Laupichler, M. C., Aster, A., Schirch, J., & Raupach, T. (2022). Artificial intelligence literacy in higher and adult education: A scoping literature review. Computers and Education: Artificial Intelligence, 3, 100101. https://doi.org/ 10.1016/j.caeai.2022.100101

Long, D., & Magerko, B. (2020). What is AI literacy? Competencies and design considerations. In Proceedings of the 2020 CHI Conference on Human Factors in Computing Systems (CHI ‘20), New York, NY, USA (pp. 1–16). Association for Computing Machinery.

Mouta, A., Pinto-Llorente, A. M., & Torrecilla-Sánchez, E. M. (2023). Uncovering blind spots in education ethics: Insights from a systematic literature review on artificial intelligence in education. International Journal of Artificial Intelligence in Education, 1–40.

Bio

Marcella Milana es Profesora Asociada en la Universidad de Verona y Profesora Honoraria de Educación de Adultos en la Universidad de Nottingham. Está especializada en educación de adultos y ha investigado y escrito extensamente sobre la gobernanza, las políticas y las prácticas de la educación de adultos. También es vicepresidenta de la Sociedad Europea para la Educación de Adultos (ESREA), redactora jefe de la Revista Internacional de Educación Permanente y experta en aprendizaje de adultos de EPALE.

Traduccións: NSS España

Comentario

Rokes od stakeholders in developing codes of conduct

I do agree with the post-provider that developing codes of conduct is crucial for educational providers to support an ethically sound practice in using AI-powered tools by educators and learning while advancing their AI capabilities.

However, there are also questions upon which stakeholders could be involved in developing voluntary codes of conduct since there are diverse interests upon the use of AI, therefore, it nees a certain level of self-limitation in using AI to provide enough freedom not to over- / under-regulate this matter. Namely, an immensely accurate development of codes are necessary to make it real and human-oriented.

- Inicie sesión o registrese para enviar comentarios

Rapid developments remain a challenge

A timely and important discussion. As AI tools become more common in education, it’s essential to ensure they are used ethically and responsibly, especially in adult learning contexts. One of the key challenges I see is that educators especially in adult education and the education system as a whole are struggling to keep pace with rapid developments in AI and AI tools. These changes are also affecting adult learners and other students. While AI continues to advance quickly, many individuals are still struggling with basic digital literacy skills.

- Inicie sesión o registrese para enviar comentarios

Thank you for this…

Thank you for this thoughtful and timely article, Marcella! Ethical use of AI in adult education is a crucial topic, especially as AI tools become increasingly integrated into teaching and learning. I fully agree that educators need not only technical skills but also critical thinking, intellectual honesty, and awareness of risks and rights when working with AI.

For educators and trainers who wish to develop their AI skills and explore these ethical and pedagogical aspects together with colleagues from across Europe, we warmly invite you to our Erasmus+ training course “AI Tools for Meaningful Learning and Training”. The course offers hands-on experience with AI tools, discussions on ethical dilemmas, and opportunities to build your own AI toolbox for different stages of the learning process.

A few places are still available for the upcoming course in Malta!